隨著人工智能(AI)技術(shù)的快速發(fā)展,訓(xùn)練大規(guī)模模型已成為行業(yè)常態(tài)。單個(gè)計(jì)算節(jié)點(diǎn)的資源限制常導(dǎo)致訓(xùn)練時(shí)間過長,甚至無法完成任務(wù)。分布式訓(xùn)練技術(shù)應(yīng)運(yùn)而生,通過將計(jì)算任務(wù)分解到多個(gè)節(jié)點(diǎn)并行處理,有效提升了訓(xùn)練效率和模型性能。

分布式訓(xùn)練的核心方法包括數(shù)據(jù)并行和模型并行。數(shù)據(jù)并行將訓(xùn)練數(shù)據(jù)分割到不同節(jié)點(diǎn),每個(gè)節(jié)點(diǎn)持有完整的模型副本,通過梯度同步(如使用All-Reduce算法)實(shí)現(xiàn)參數(shù)更新;模型并行則將模型結(jié)構(gòu)拆分到不同節(jié)點(diǎn),適用于超大規(guī)模模型(如GPT-4),解決單個(gè)設(shè)備內(nèi)存不足的問題。混合并行策略結(jié)合了兩者優(yōu)勢,例如在Megatron-LM等框架中廣泛應(yīng)用。關(guān)鍵技術(shù)如參數(shù)服務(wù)器架構(gòu)和All-Reduce通信優(yōu)化(如Ring-AllReduce)進(jìn)一步降低了通信開銷。

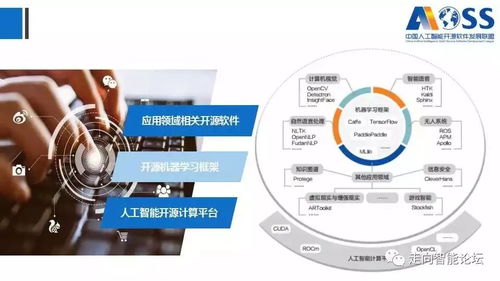

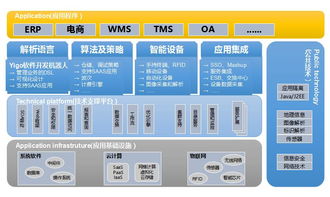

在人工智能應(yīng)用軟件開發(fā)中,分布式訓(xùn)練技術(shù)顯著加速了產(chǎn)品迭代。以智能語音助手為例,開發(fā)團(tuán)隊(duì)可利用Horovod或PyTorch Distributed框架,在GPU集群上并行訓(xùn)練聲學(xué)模型,將數(shù)周的訓(xùn)練時(shí)間縮短至幾天。分布式訓(xùn)練支持更大規(guī)模數(shù)據(jù)的處理,提升了模型在復(fù)雜場景下的準(zhǔn)確性,如自動駕駛系統(tǒng)中的視覺識別模塊。開發(fā)者需注意數(shù)據(jù)分布一致性、節(jié)點(diǎn)故障恢復(fù)等挑戰(zhàn),并借助Kubernetes等工具實(shí)現(xiàn)彈性資源調(diào)度。

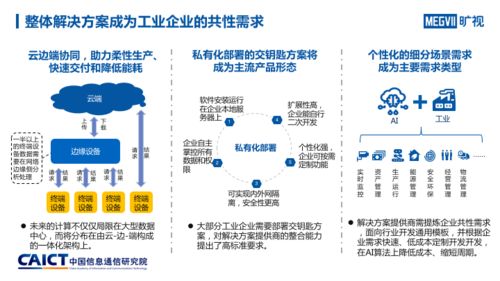

隨著異構(gòu)計(jì)算和聯(lián)邦學(xué)習(xí)等技術(shù)的融合,分布式訓(xùn)練將進(jìn)一步推動AI應(yīng)用軟件的創(chuàng)新,幫助企業(yè)在醫(yī)療、金融等領(lǐng)域?qū)崿F(xiàn)高效智能化轉(zhuǎn)型。